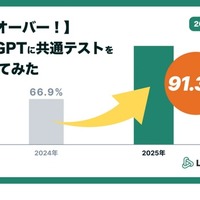

【共通テスト2025】ChatGPTの正答率9割超…ついに東大合格レベルに

子育て・教育

リセマム/教育ICT/その他

LifePromptでは、2023・2024年度と「大学受験 vs 生成AI」をテーマに、共通テストを生成AIに解かせる実験をしてきた。3年目となる今回は、ChatGPTに2025年度共通テストの問題を解かせる実験を実施。速度・精度の観点からOpenAI社のChatGPT o1モデルを使用し、英語(リーディング・リスニング)、国語、数学(数学I、数学A・数学II、数学B、数学C)、社会(歴史総合、世界史探究・歴史総合、日本史探究)、理科基礎(地学基礎・生物基礎)、情報(情報1)の6教科8科目の回答に挑戦した。

手順としては、問題のスクリーンショットを張り付け、画像以外は入力せずに送信し、回答を出力させる方法で実施。国語は文字起こし結果を併用、また英語リスニングは音声公開がないため、スクリプトを直接入力した。問題に回答しない場合は「問題に回答して」「選択肢○○にあてはまる答えは何?」などを入力。スクリーンショットの認識が大きく誤っている場合は、該当個所を抜き取り、再度入力したという。

結果、1,000点満点中913点となり、正答率は驚きの91.3%を記録。前年度の66.9%から24.4ポイントと大きく得点率を伸ばし、例年の共通試験のボーダーを参考にすると東大合格レベルの得点となった。科目別でみると、全科目で前年度より得点がアップ。特に、国語と数学の点数の伸びが大きく、数学1Aでは前年度の正答率35%から80%へと倍以上の成長を遂げた。

LifePromptは、得点が伸びた要因として、「図表の読み取りができるようになった」「数理計算能力の向上」「言語モデル特有のミスが減った」という3点をあげている。最大の要因は、複数の種類のデータを組みあわせたり、関連付けたりして処理するマルチモーダル化が実装されたことだという。これにより、前年までまったく対応できなかった図表の読み取りやイラスト問題に対応できるようになり、大きく点数を伸ばすことにつながった。数理計算能力の向上もめざましく、o1モデルは現在、東大の数学でほぼ満点を取れるレベルまで進化しているという。

一方、細かなイラストの違いを読み取り、理解して答える問題や、空間図形を想像し作図するような問題、日本史の知識問題でミスがみられたという。「思考部分をさらに強化したo1 proを使えばさらに正答率が高まるのではないか」と思いがちだが、LifePromptによると、意外とそうでもないという。ミスの原因が図表の読み取りや知識の部分にあり、その先の思考の部分においては共通テストの範囲では大きな差は見られないからだ。

今回、AIの知能タスクにおける速度と正確性の進化を裏付ける結果となった一方、まだ10%はミスをするという事実、その傾向も浮き彫りとなった。LifePromptでは、2025年も東大受験企画を始動しており、今回の結果とあわせて東大にチャレンジするという。ついにAIが東大合格となるのか、今後の結果に注目したい。

《畑山望》

この記事の写真

/